|

| Ảnh minh họa. |

|

| Ảnh minh họa. |

|

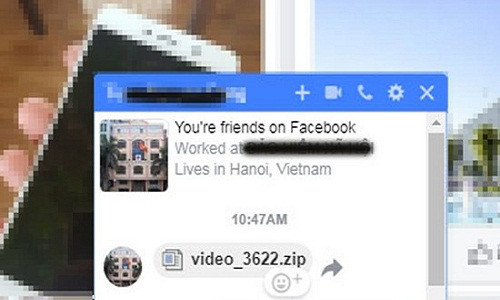

| Loại mã độc mới giả mạo file video đang được lây lan mạnh tại Việt Nam qua ứng dụng Facebook Messenger (Ảnh minh họa: VnReview.vn) |

Theo chuyên gia, khi được chăm sóc đúng cách, quất cảnh có thể trở thành cây cảnh lâu năm, mang sắc xuân trở lại mỗi mùa Tết.

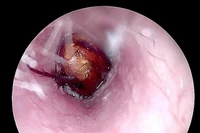

Khi phát hiện côn trùng chui vào tai, người bệnh đã đến tiệm cắt tóc để lấy nhưng không được, sau đó được người nhà đưa đến bệnh viện thăm khám.

Vẻ đẹp trầm lắng, chất thơ và nhịp sống chậm giúp Huế lọt top điểm đến trăng mật lãng mạn nhất thế giới 2026, ghi dấu ấn trên bản đồ du lịch.

Một số thói quen buổi giúp não bộ hoạt động hiệu quả, ngăn ngừa lão hóa, tăng cường tập trung và tinh thần sảng khoái để khởi đầu ngày mới.

Hạt macca giúp giảm cholesterol, hỗ trợ hệ tiêu hóa, làm đẹp da và tóc, đồng thời tăng cường sức khỏe xương và kiểm soát đường huyết.

Sau những ngày Tết, việc lắng nghe các tín hiệu cảnh báo của cơ thể chính là bước quan trọng để bảo vệ sức khỏe lâu dài trong năm mới.

Không chỉ vàng hay heo quay, cá lóc nướng là lễ vật quen thuộc trong ngày vía Thần Tài của người miền Nam, mang ý nghĩa cầu tài lộc, may mắn và bứt phá đầu năm.

Các chuyên gia cảnh báo tác hại của bụi mịn đối với mắt, khuyến khích người dân theo dõi chất lượng không khí và thực hiện các biện pháp bảo vệ đúng cách.

Nồm ẩm khiến sàn nhà “đổ mồ hôi”, đồ đạc ẩm mốc và bốc mùi khó chịu. Chỉ với vài mẹo đơn giản dưới đây đã bạn có thể giữ không gian sống luôn khô ráo, dễ chịu.

Dù giàu protein và vitamin, cá lóc cần hạn chế với người mắc bệnh gout, gan, thận hoặc dị ứng để tránh rủi ro sức khỏe.

Dù giàu protein và vitamin, cá lóc cần hạn chế với người mắc bệnh gout, gan, thận hoặc dị ứng để tránh rủi ro sức khỏe.

Bổ sung nước, ăn uống cân bằng thực phẩm và lối sống lành mạnh giúp gan khỏe mạnh, giảm tổn thương do rượu bia gây ra.

Khi phát hiện côn trùng chui vào tai, người bệnh đã đến tiệm cắt tóc để lấy nhưng không được, sau đó được người nhà đưa đến bệnh viện thăm khám.

Vẻ đẹp trầm lắng, chất thơ và nhịp sống chậm giúp Huế lọt top điểm đến trăng mật lãng mạn nhất thế giới 2026, ghi dấu ấn trên bản đồ du lịch.

Nồm ẩm khiến sàn nhà “đổ mồ hôi”, đồ đạc ẩm mốc và bốc mùi khó chịu. Chỉ với vài mẹo đơn giản dưới đây đã bạn có thể giữ không gian sống luôn khô ráo, dễ chịu.

Các chuyên gia cảnh báo tác hại của bụi mịn đối với mắt, khuyến khích người dân theo dõi chất lượng không khí và thực hiện các biện pháp bảo vệ đúng cách.

Theo chuyên gia, khi được chăm sóc đúng cách, quất cảnh có thể trở thành cây cảnh lâu năm, mang sắc xuân trở lại mỗi mùa Tết.

Sau những ngày Tết, việc lắng nghe các tín hiệu cảnh báo của cơ thể chính là bước quan trọng để bảo vệ sức khỏe lâu dài trong năm mới.

Không chỉ vàng hay heo quay, cá lóc nướng là lễ vật quen thuộc trong ngày vía Thần Tài của người miền Nam, mang ý nghĩa cầu tài lộc, may mắn và bứt phá đầu năm.

Chỉ vài thói quen nhỏ trước khi ngủ có thể giúp mái tóc giảm xơ rối, giữ độ ẩm tự nhiên và mềm mượt hơn khi thức dậy mà không cần tốn nhiều công chăm sóc.

Hạt macca giúp giảm cholesterol, hỗ trợ hệ tiêu hóa, làm đẹp da và tóc, đồng thời tăng cường sức khỏe xương và kiểm soát đường huyết.

Tiết trời nồm ẩm, mưa phùn đầu xuân khiến nguy cơ cảm cúm, bệnh hô hấp gia tăng. Giữ ấm, ăn uống hợp lý và sinh hoạt khoa học giúp bảo vệ sức khỏe hiệu quả.

Một số thói quen buổi giúp não bộ hoạt động hiệu quả, ngăn ngừa lão hóa, tăng cường tập trung và tinh thần sảng khoái để khởi đầu ngày mới.

Trữ nem rán đúng cách giúp duy trì chất lượng và an toàn thực phẩm, tránh nguy cơ nhiễm khuẩn, mất dinh dưỡng.

Khám phá 5 món salad ngon, bổ dưỡng giúp thanh lọc cơ thể, giảm mỡ và lấy lại vóc dáng sau kỳ nghỉ Tết hiệu quả, an toàn.

Bánh bao túi tiền không chỉ thơm ngon mà còn mang ý nghĩa tài lộc. Món bánh vàng ươm này được nhiều người chọn dâng cúng ngày vía Thần Tài, cầu may mắn đầu năm.

Mùa xuân miền Bắc là thời điểm vàng để trekking khi rừng xanh non, hoa đỗ quyên nở rộ và biển mây dày. Nhiều cung leo núi đẹp đang hút du khách mê khám phá.

Sau những ngày Tết nhiều thịt mỡ, bánh chưng dễ ngán, các món bún, phở nóng hổi với nước dùng thanh nhẹ sẽ giúp cả nhà đổi vị, ăn ngon mà vẫn nhẹ bụng.

Chuối chín nhiều sau Tết khiến một số người lo bỏ phí. Chỉ với vài nguyên liệu quen thuộc, bạn có thể làm ngay loạt món ngon vừa tiết kiệm vừa hấp dẫn.

Các bài tập cardio đến tập kháng lực... giúp bạn giảm cân, săn chắc cơ bụng và nâng cao thể lực sau kỳ nghỉ Tết.