Các nhà nghiên cứu tại Apple Computer Company đã tìm thấy bằng chứng, thông qua thử nghiệm, cho thấy rằng các phản ứng có vẻ thông minh do các mô hình ngôn ngữ lớn (LLM) dựa trên AI đưa ra chỉ là ảo tưởng.

Trong bài báo được đăng trên máy chủ bản thảo arXiv, các nhà nghiên cứu lập luận rằng sau khi thử nghiệm một số LLM, họ thấy rằng chúng không có khả năng thực hiện suy luận logic thực sự.

Trong vài năm qua, nhiều LLM như ChatGPT đã phát triển đến mức nhiều người dùng bắt đầu tự hỏi liệu họ có thực sự sở hữu trí thông minh hay không. Trong nỗ lực mới này, nhóm tại Apple đã giải quyết câu hỏi bằng cách cho rằng câu trả lời nằm ở khả năng của một sinh vật thông minh, hoặc máy móc, để hiểu được những sắc thái hiện diện trong những tình huống đơn giản, đòi hỏi phải có lý luận logic.

|

| Việc thiếu tư duy logic khiến cho các Chatbot AI không đủ khả năng suy luận để tách lọc thông tin mà chỉ nhận ra cấu trúc của một câu thông qua thuật toán máy học mà thôi. Ảnh: Languae Links |

Một sắc thái như vậy là khả năng tách thông tin có liên quan khỏi thông tin không liên quan. Ví dụ, nếu một đứa trẻ hỏi cha mẹ có bao nhiêu quả táo trong một túi, đồng thời lưu ý rằng một số quả quá nhỏ để ăn, thì cả đứa trẻ và cha mẹ đều hiểu rằng kích thước của những quả táo không liên quan gì đến số lượng chúng có mặt.

Điều này là do cả hai đều có khả năng suy luận logic. Trong nghiên cứu mới này, các nhà nghiên cứu đã kiểm tra khả năng hiểu thực sự những gì được yêu cầu của một số LLM bằng cách gián tiếp yêu cầu họ bỏ qua những thông tin không liên quan.

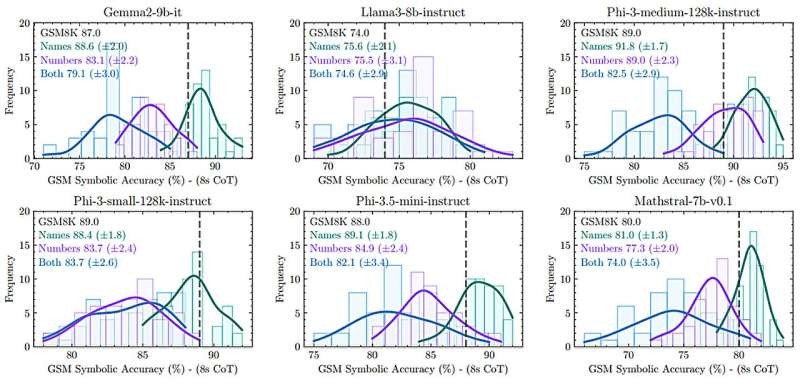

|

| Thử nghiệm của Apple thống kê sự thay đổi tên, con số hoặc kết hợp các 2 cũng đủ khiến các AI đưa ra câu trả lời sai lệch mà trước đó nó vốn trả lời đúng. Ảnh: Apple Computer |

Việc thử nghiệm của họ bao gồm việc hỏi nhiều LLM hàng trăm câu hỏi đã từng được sử dụng trước đây như một phương tiện để kiểm tra khả năng của LLM—nhưng các nhà nghiên cứu cũng đưa vào một số thông tin không liên quan. Và họ thấy rằng, điều đó đủ để khiến các LLM đưa ra câu trả lời sai hoặc thậm chí vô nghĩa cho những câu hỏi mà trước đó chúng đã trả lời đúng.

Các nhà nghiên cứu cho rằng điều này cho thấy các LLM không thực sự hiểu những gì nó được hỏi. Thay vào đó, nó nhận ra cấu trúc của một câu và sau đó đưa ra câu trả lời dựa trên những gì nó đã học được thông qua các thuật toán học máy.

Các kỹ sư của Apple cũng lưu ý rằng hầu hết các LLM mà họ thử nghiệm thường đưa ra câu trả lời có vẻ đúng, nhưng khi xem xét kỹ hơn thì không phải, chẳng hạn như khi được hỏi AI "cảm thấy" thế nào về điều gì đó. Các AI thay vì đưa ra những nhận định, chúng đã đáp lại một cách "vô tri" cho thấy rằng AI nghĩ nó có khả năng thực hiện hành vi như vậy.