Theo WSJ, hệ thống huấn luyện trí tuệ nhân tạo (AI) được Nvidia bán cho các trung tâm dữ liệu lớn. Ví dụ, tủ máy chủ DGX H100 có kích thước tương đương thùng container, chứa 32 hộp chip DGX nhỏ hơn.Phía sau tủ máy chủ là hệ thống cáp mạng và những thiết bị giúp tăng tốc độ truyền dữ liệu. Khác với chip máy tính thông thường chỉ thực hiện một tác vụ mỗi lúc (xử lý tuần tự), GPU có thể làm nhiều phép tính cùng lúc (xử lý song song). Ban đầu được thiết kế giúp cải thiện đồ họa game, GPU dần được sử dụng rộng rãi cho AI từ năm 2012.Mỗi hộp DGX con nặng khoảng 136 kg, chứa các thành phần như bộ xử lý đồ họa (GPU), module mạng tốc độ cao để kết nối GPU đến những thành phần khác trong máy chủ.Có 8 GPU H100 trong mỗi hộp DGX, bên cạnh hệ thống tản nhiệt và một số thành phần bổ sung. Chúng bao gồm 2 CPU Intel Xeon, 2 ổ cứng SSD 1,92 TB cho hệ điều hành, 8 ổ cứng 3,84 TB cho bộ nhớ đệm (cache), 32 thanh RAM (tổng dung lượng 2 TB)…Được sản xuất bằng robot trong các nhà máy tự động tại Đài Loan, GPU H100 trị giá khoảng 25.000 USD/chiếc. Có thể cầm trên lòng bàn tay, mỗi GPU chứa 80 tỷ bóng bán dẫn cho những tác vụ tính toán phức tạp. Do giá trị cao, công ty mạng Cisco Systems từng dùng xe bọc thép để vận chuyển các GPU đặt từ Nvidia.Theo Nvidia, các hệ thống này trở thành công cụ quan trọng cho sự bùng nổ của AI nhờ phần cứng mạnh và phần mềm tối ưu. Công ty công nghệ sử dụng những máy chủ này cho trung tâm dữ liệu để huấn luyện mô hình AI. Nhu cầu mua GPU cao giúp doanh thu của Nvidia tăng vọt trong thời gian gần đây.

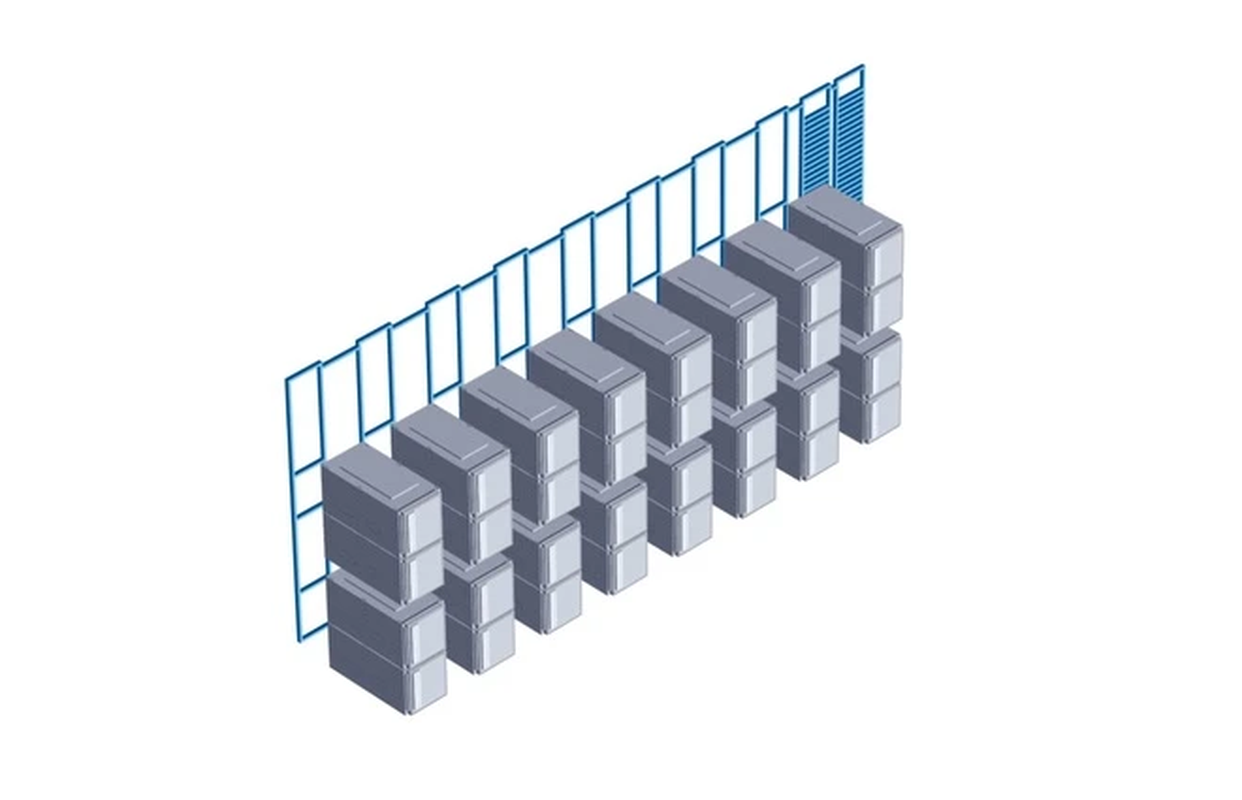

Theo WSJ, hệ thống huấn luyện trí tuệ nhân tạo (AI) được Nvidia bán cho các trung tâm dữ liệu lớn. Ví dụ, tủ máy chủ DGX H100 có kích thước tương đương thùng container, chứa 32 hộp chip DGX nhỏ hơn.

Phía sau tủ máy chủ là hệ thống cáp mạng và những thiết bị giúp tăng tốc độ truyền dữ liệu. Khác với chip máy tính thông thường chỉ thực hiện một tác vụ mỗi lúc (xử lý tuần tự), GPU có thể làm nhiều phép tính cùng lúc (xử lý song song). Ban đầu được thiết kế giúp cải thiện đồ họa game, GPU dần được sử dụng rộng rãi cho AI từ năm 2012.

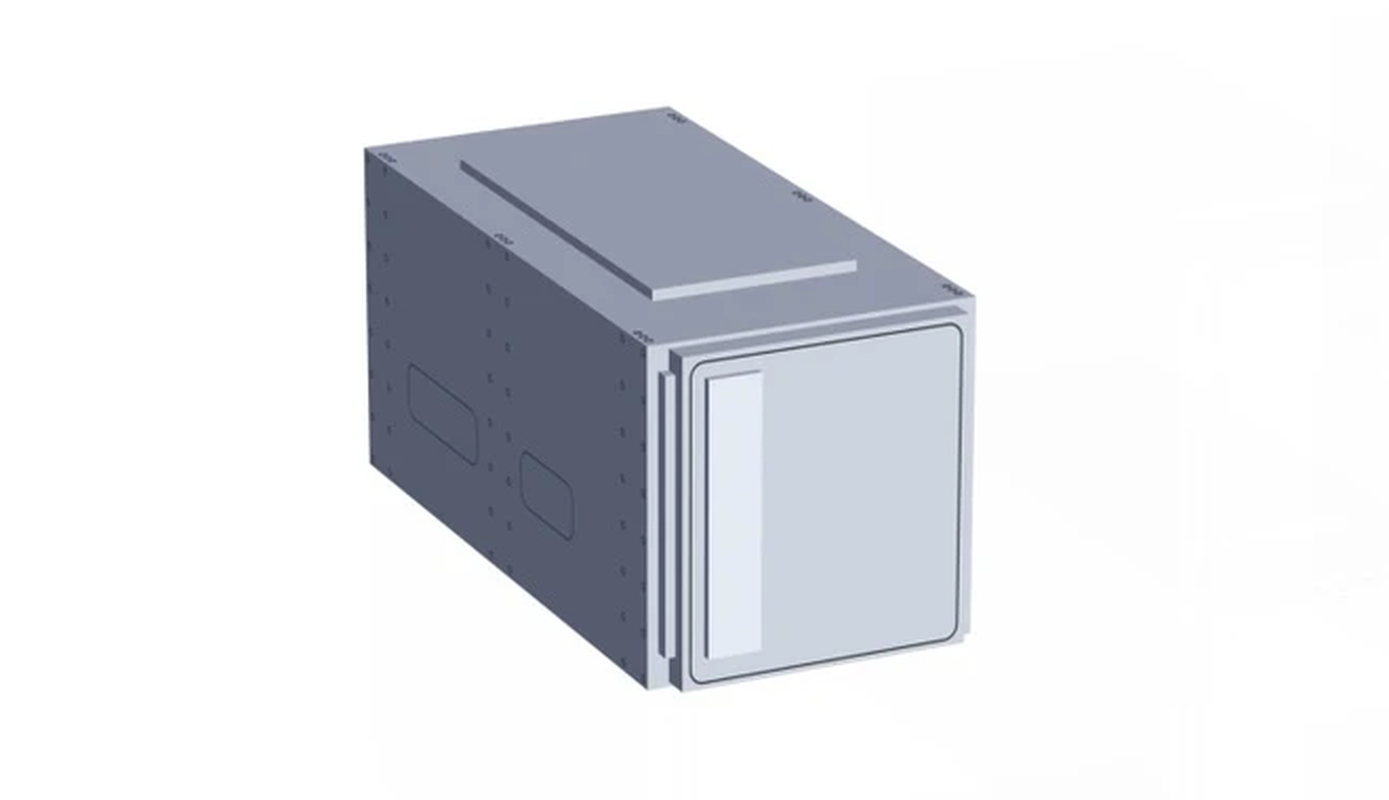

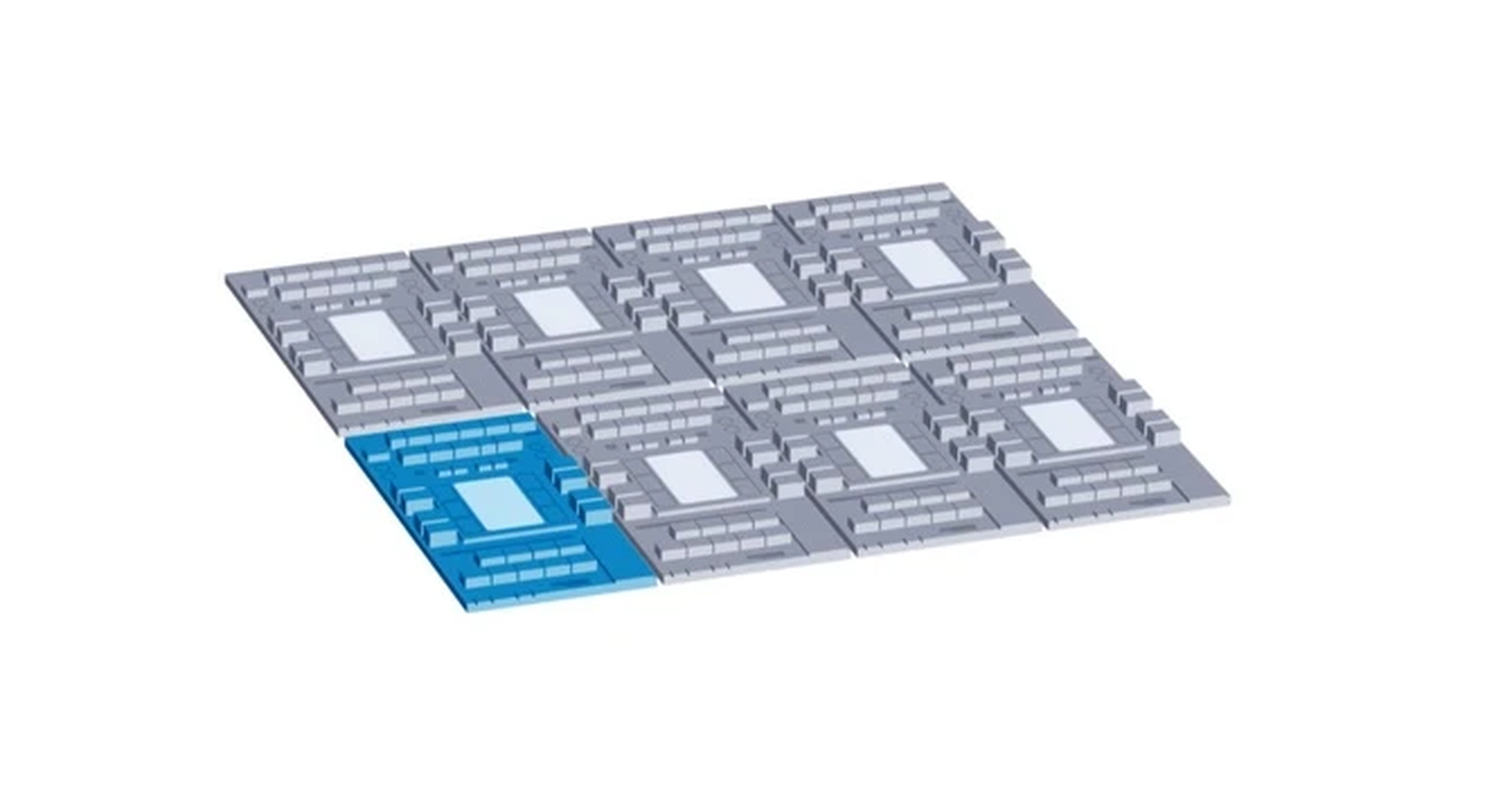

Mỗi hộp DGX con nặng khoảng 136 kg, chứa các thành phần như bộ xử lý đồ họa (GPU), module mạng tốc độ cao để kết nối GPU đến những thành phần khác trong máy chủ.

Có 8 GPU H100 trong mỗi hộp DGX, bên cạnh hệ thống tản nhiệt và một số thành phần bổ sung. Chúng bao gồm 2 CPU Intel Xeon, 2 ổ cứng SSD 1,92 TB cho hệ điều hành, 8 ổ cứng 3,84 TB cho bộ nhớ đệm (cache), 32 thanh RAM (tổng dung lượng 2 TB)…

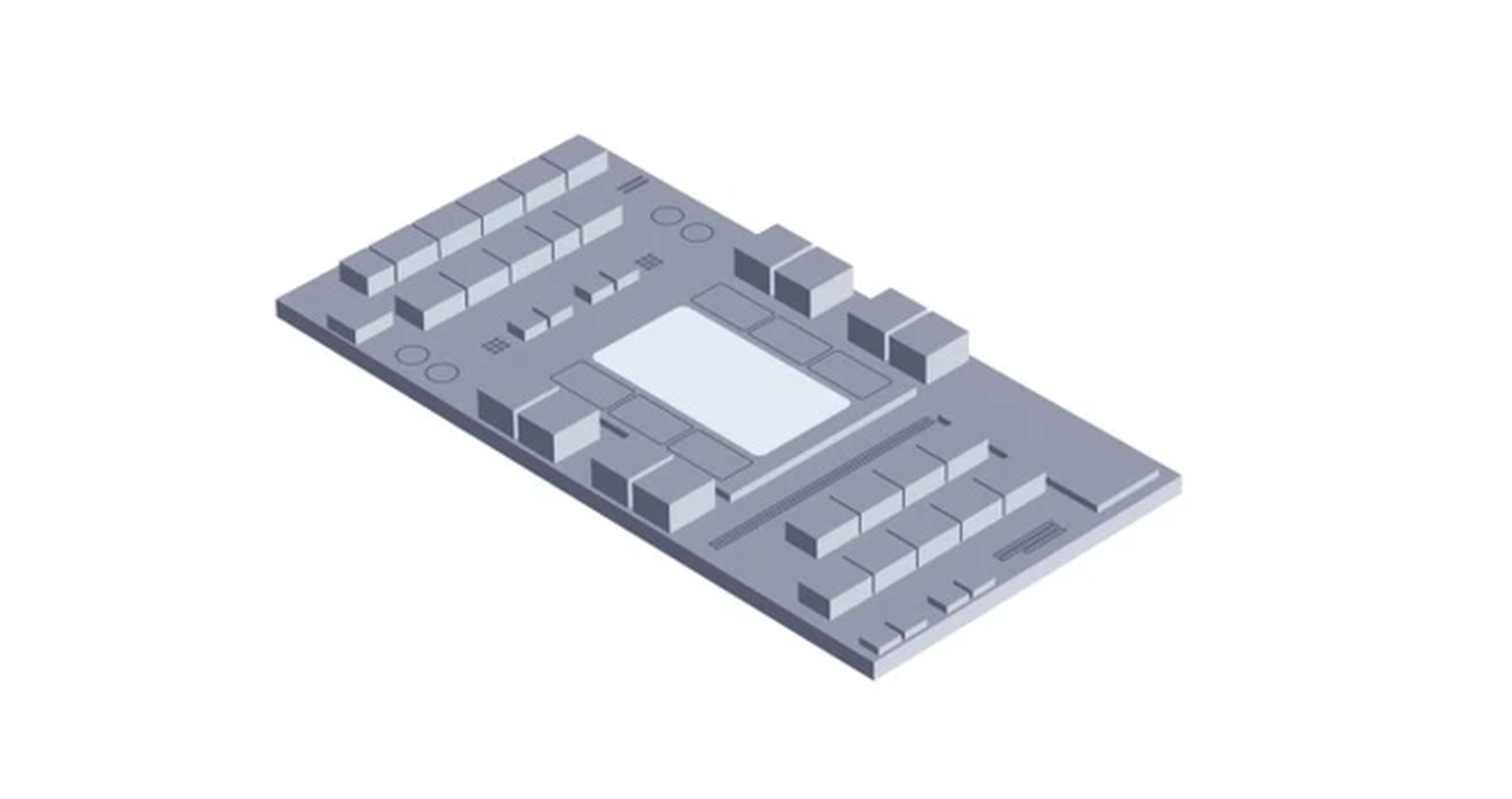

Được sản xuất bằng robot trong các nhà máy tự động tại Đài Loan, GPU H100 trị giá khoảng 25.000 USD/chiếc. Có thể cầm trên lòng bàn tay, mỗi GPU chứa 80 tỷ bóng bán dẫn cho những tác vụ tính toán phức tạp. Do giá trị cao, công ty mạng Cisco Systems từng dùng xe bọc thép để vận chuyển các GPU đặt từ Nvidia.

Theo Nvidia, các hệ thống này trở thành công cụ quan trọng cho sự bùng nổ của AI nhờ phần cứng mạnh và phần mềm tối ưu. Công ty công nghệ sử dụng những máy chủ này cho trung tâm dữ liệu để huấn luyện mô hình AI. Nhu cầu mua GPU cao giúp doanh thu của Nvidia tăng vọt trong thời gian gần đây.